Was ist AI-Hacking?

Unter KI-Hacking versteht man den Einsatz künstlicher Intelligenz zur Verbesserung oder Automatisierung von Cyberangriffen. Sie ermöglicht es Bedrohungsakteuren, mit minimalem manuellem Aufwand Code zu generieren, Systeme zu analysieren und Abwehrmaßnahmen zu umgehen.

KI-Modelle, insbesondere große Sprachmodelle (LLMs), machen die Entwicklung von Angriffen schneller, billiger und für weniger erfahrene Hacker zugänglicher. Das Ergebnis ist eine neue Art von KI-Angriffen, die schneller und skalierbarer sind und sich mit herkömmlichen Abwehrmaßnahmen oft nur schwer stoppen lassen.

Was ist ein KI-Hacker?

Ein KI-Hacker ist ein Bedrohungsakteur, der künstliche Intelligenz einsetzt, um Cyberangriffe zu automatisieren, zu verbessern oder auszuweiten. KI-Hacker nutzen maschinelle Lernmodelle, generative KI und autonome Agenten, um Sicherheitskontrollen zu umgehen, äußerst überzeugende Phishing-Angriffe zu entwickeln und Software-Schwachstellen in großem Umfang auszunutzen.

Diese Angreifer können sowohl menschliche Operatoren sein, die KI-Tools verwenden, als auch halbautonome Systeme, die Aufgaben mit minimalen menschlichen Eingaben ausführen. Menschliche Angreifer, die KI nutzen, sind reale Personen - Kriminelle, Script-Kiddies, Hacktivisten oder staatliche Akteure -, die KI-Modelle nutzen, um ihre Angriffsfähigkeiten zu verbessern.

Autonome Hacking-Agenten sind KI-gesteuerte Arbeitsabläufe, die Aufgaben wie Aufklärung, Generierung von Nutzlasten und Umgehung von Angriffen mit minimaler Überwachung verketten können. Diese Agenten werden zwar immer noch von menschlich definierten Zielen geleitet, können aber nach dem Start halbautonom arbeiten und mehrstufige Angriffe effizienter durchführen als manuelle Tools.

Wie wird KI für Cyberkriminalität eingesetzt?

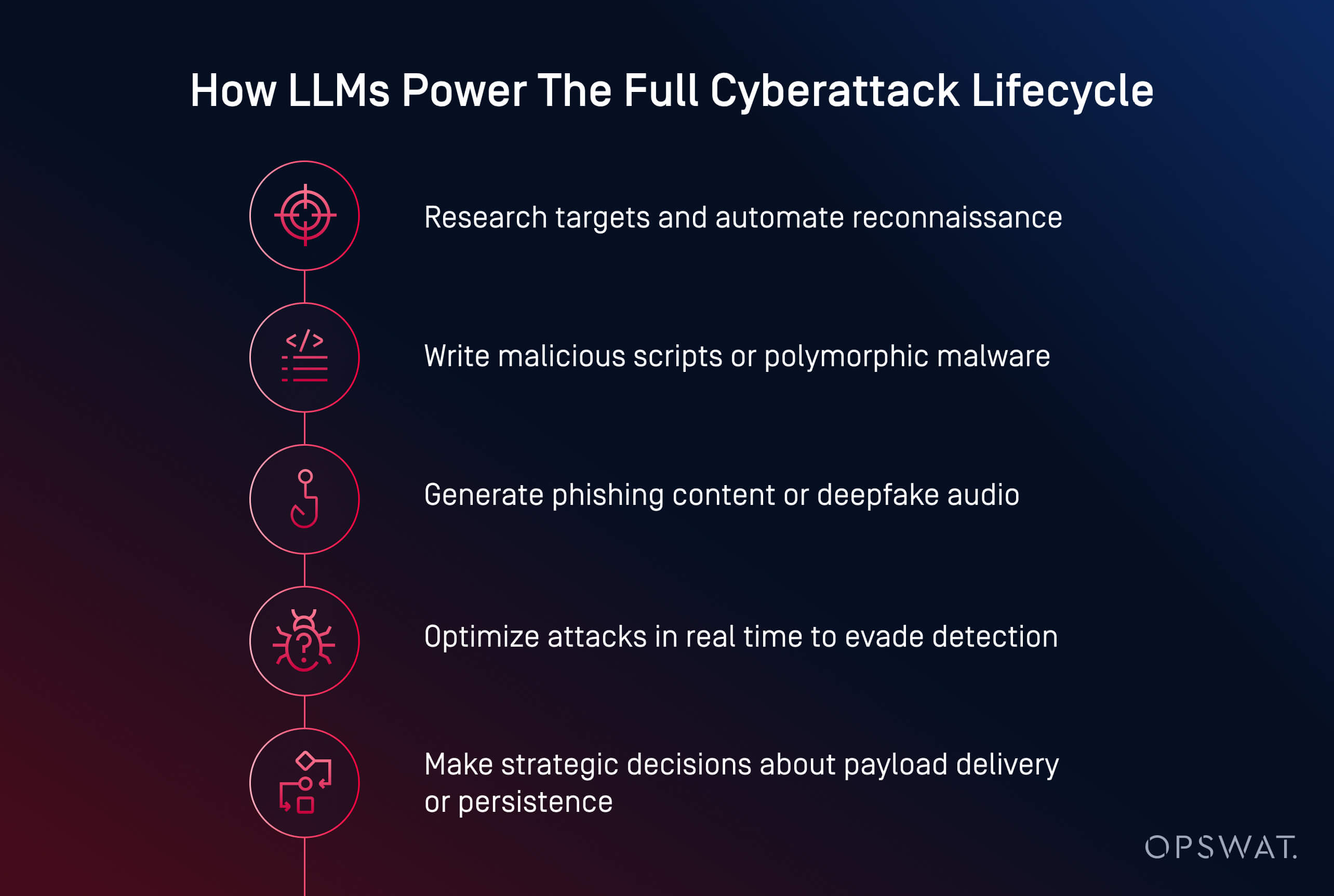

KI-Bedrohungsakteure nutzen jetzt künstliche Intelligenz, um schnellere, intelligentere und anpassungsfähigere Cyberangriffe zu starten. Von der Malware-Erstellung bis zur Phishing-Automatisierung verwandelt KI die Cyberkriminalität in eine skalierbare Operation. Sie kann jetzt bösartigen Code generieren, überzeugende Phishing-Inhalte verfassen und Angreifer sogar durch komplette Angriffsketten führen.

Cyberkriminelle nutzen KI in mehreren Kernbereichen:

- Generierung von Nutzdaten: Tools wie HackerGPT und WormGPT können verschleierte Malware schreiben, Umgehungstaktiken automatisieren und Skripte in ausführbare Dateien umwandeln. Dies sind Beispiele für generative KI-Angriffe, wie sie häufig bei KI-Agenten-Cyberangriffen zu beobachten sind, bei denen Modelle autonome Entscheidungen treffen.

- Social Engineering: KI erstellt realistische Phishing-E-Mails, klont Stimmen und erzeugt Deepfakes, um Opfer effektiver zu manipulieren.

- Aufklären und Planen: KI beschleunigt die Zielsuche, die Kartierung der Infrastruktur und die Identifizierung von Schwachstellen.

- Automatisierung in großem Maßstab: Angreifer nutzen KI, um mehrstufige Kampagnen mit minimalem menschlichen Einsatz zu starten.

Nach Angaben des Ponemon Institute wurde KI bereits für Ransomware-Kampagnen und Phishing-Angriffe eingesetzt, die zu erheblichen Betriebsunterbrechungen führten, einschließlich des Diebstahls von Zugangsdaten und der erzwungenen Schließung von mehr als 300 Einzelhandelsgeschäften während einer Sicherheitsverletzung im Jahr 2023.

Die Bedrohungslandschaft wird durch mehrere neue Muster umgestaltet:

- Demokratisierung von Cyberangriffen: Open-Source-Modelle wie LLaMA, die auf Angriffe abgestimmt sind, stehen nun jedem zur Verfügung, der über lokale Rechenleistung verfügt

- Niedrigere Einstiegshürde: Was früher Expertenwissen erforderte, kann jetzt mit einfachen Aufforderungen und ein paar Klicks erledigt werden

- Erfolgreichere Umgehung: KI-generierte Malware ist besser in der Lage, sich vor statischer Erkennung, Sandboxen und sogar dynamischer Analyse zu verstecken

- Malware-as-a-Service-Modelle (MaaS): Cyberkriminelle bündeln KI-Funktionen in abonnementbasierten Kits, um komplexe Angriffe in großem Maßstab zu starten

- Einsatz von KI bei realen Sicherheitsverletzungen: Das Ponemon Institute berichtet, dass Angreifer bereits KI eingesetzt haben, um Ransomware-Angriffe zu automatisieren, unter anderem bei Vorfällen, die die Schließung großer Betriebe erzwungen haben

KI-gestütztes Phishing und Social Engineering

KI-gestütztes Phishing und Social Engineering mit KI verwandeln herkömmliche Betrügereien in skalierbare, personalisierte Angriffe, die schwieriger zu erkennen sind. Bedrohungsakteure verwenden jetzt generative Modelle, um glaubwürdige E-Mails zu erstellen, Stimmen zu klonen und sogar gefälschte Videoanrufe zu produzieren, um ihre Ziele zu manipulieren.

Im Gegensatz zu herkömmlichen Betrügereien sind KI-generierte Phishing-E-Mails ausgefeilt und überzeugend. Tools wie ChatGPT und WormGPT erstellen Nachrichten, die interne Kommunikation, Kundendienstleistungen oder HR-Updates imitieren. In Verbindung mit verletzten Daten werden diese E-Mails personalisiert und haben eine höhere Erfolgswahrscheinlichkeit.

KI ermöglicht auch neuere Formen des Social Engineering:

- Voice-Cloning-Angriffe imitieren Führungskräfte mit kurzen Audiosamples, um dringende Aktionen wie Überweisungen auszulösen

- Deepfake-Angriffe simulieren Videoanrufe oder Fernsitzungen für Betrügereien mit hohem Risiko

Bei einem kürzlich aufgetretenen Vorfall verwendeten Angreifer KI-generierte E-Mails während einer Anmeldephase für Sozialleistungen und gaben sich als Personalabteilung aus, um Anmeldedaten zu stehlen und Zugriff auf Mitarbeiterdaten zu erhalten. Die Gefahr liegt in der Illusion des Vertrauens. Wenn eine E-Mail intern aussieht, die Stimme vertraut klingt und die Anfrage dringend erscheint, können selbst geschulte Mitarbeiter getäuscht werden.

Entdeckung und Ausnutzung von Schwachstellen durch KI

KI beschleunigt die Art und Weise, wie Angreifer Software-Schwachstellen finden und ausnutzen. Was früher tagelange manuelle Sondierungen erforderte, kann heute mithilfe von Modellen für maschinelles Lernen, die für die Erkundung und Generierung von Exploits trainiert wurden, in wenigen Minuten erledigt werden.

Bedrohungsakteure nutzen KI, um Schwachstellen in öffentlich zugänglichen Systemen automatisch zu scannen und schwache Konfigurationen, veraltete Software oder ungepatchte CVEs zu identifizieren. Im Gegensatz zu herkömmlichen Tools kann KI den Kontext der Gefährdung bewerten, um Angreifern zu helfen, hochwertige Ziele zu priorisieren.

Zu den üblichen KI-gestützten Ausbeutungstaktiken gehören:

- Automatisiertes Fuzzing zur schnelleren Aufdeckung von Zero-Day-Schwachstellen

- Benutzerdefinierte Skripterstellung für Remote-Code-Ausführung oder laterale Bewegungen

- Passwortknacken und Brute-Force-Angriffe optimiert durch Musterlernen und probabilistische Modelle

- Aufklärungsbots, die Netze mit minimalem Rauschen nach risikoreichen Assets scannen

Generative Modelle wie LLaMA, Mistral oder Gemma können fein abgestimmt werden, um maßgeschneiderte Nutzdaten wie Shellcode oder Injektionsangriffe auf der Grundlage systemspezifischer Merkmale zu generieren und dabei häufig die in kommerziellen Modellen eingebauten Sicherheitsvorkehrungen zu umgehen.

Der Trend ist eindeutig: KI ermöglicht es Angreifern, Schwachstellen in Maschinengeschwindigkeit zu entdecken und zu nutzen. Laut dem Ponemon Institute nennen 54 % der Cybersicherheitsexperten ungepatchte Schwachstellen als ihre größte Sorge im Zeitalter der KI-gestützten Angriffe.

KI-gesteuerte Malware und Ransomware

Die Zunahme von KI-generierter Malware bedeutet, dass herkömmliche Verteidigungsmaßnahmen allein nicht mehr ausreichen. Angreifer verfügen jetzt über Tools, die mitdenken, sich anpassen und ausweichen - oft schneller, als menschliche Verteidiger reagieren können.

KI-gestützte Ransomware und polymorphe Malware definieren die Art und Weise, wie sich Cyberangriffe entwickeln, neu. Anstatt statische Nutzdaten zu schreiben, nutzen Angreifer jetzt KI, um polymorphe Malware zu generieren - Code, der sich ständig verändert, um nicht entdeckt zu werden.

Auch Ransomware-Bedrohungen entwickeln sich weiter. KI kann dabei helfen, die zu verschlüsselnden Dateien auszuwählen, den Systemwert zu analysieren und den optimalen Zeitpunkt für die Detonation zu bestimmen. Diese Modelle können auch Geofencing, Sandbox-Umgehung und speicherinterne Ausführung automatisieren - Techniken, die typischerweise von fortgeschrittenen Bedrohungsakteuren eingesetzt werden.

Die Datenexfiltration mit KI passt sich dynamisch an, um einer Entdeckung zu entgehen. Algorithmen können Daten komprimieren, verschlüsseln und heimlich extrahieren, indem sie Datenverkehrsmuster analysieren und so Erkennungsauslöser vermeiden. Einige Malware-Agenten fangen an, strategische Entscheidungen zu treffen: Sie entscheiden, wann, wo und wie sie exfiltrieren, je nachdem, was sie in der kompromittierten Umgebung beobachten.

Beispiele für AI-Cyberattacken

KI-Cyberangriffe sind nicht mehr nur theoretisch. Sie wurden bereits eingesetzt, um Daten zu stehlen, Schutzmaßnahmen zu umgehen und sich in großem Umfang als Menschen auszugeben.

Die Beispiele in den drei nachstehenden Kategorien zeigen, dass Angreifer keine fortgeschrittenen Fähigkeiten mehr benötigen, um bei Cyberangriffen ernsthaften Schaden anzurichten. KI senkt die Einstiegshürde und erhöht gleichzeitig die Geschwindigkeit, den Umfang und die Heimlichkeit von Angriffen. Verteidiger müssen sich darauf einstellen, indem sie KI-integrierte Systeme proaktiv testen und Schutzmaßnahmen ergreifen, die sowohl technische Manipulationen als auch menschliche Täuschungen berücksichtigen.

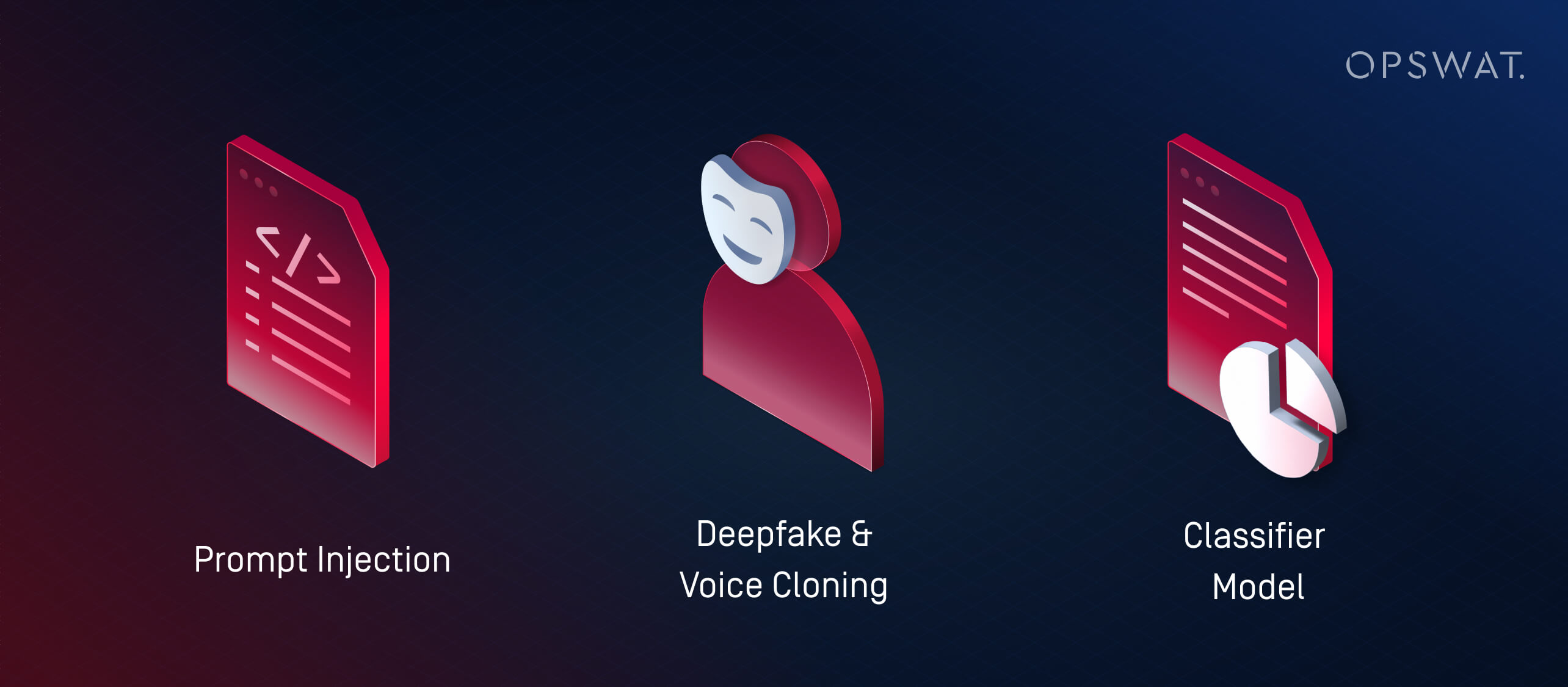

1. Was sind Prompt Injection Attacks?

Prompt Injection ist eine Technik, bei der Angreifer Schwachstellen in LLMs (Large Language Models) ausnutzen, indem sie sie mit speziell gestalteten Eingaben füttern, die das beabsichtigte Verhalten außer Kraft setzen sollen. Bei diesen Angriffen wird die Art und Weise ausgenutzt, wie LLMs Anweisungen interpretieren und priorisieren, wobei oft wenig oder gar keine herkömmliche Malware beteiligt ist.

Anstatt KI zu nutzen, um externe Angriffe zu starten, werden die KI-Systeme eines Unternehmens durch Prompt Injection zu unwissenden Agenten der Kompromittierung. Wenn ein LLM ohne angemessene Schutzmaßnahmen in Tools wie Helpdesks, Chatbots oder Dokumentenverarbeitungssysteme eingebettet wird, kann ein Angreifer versteckte Befehle einbetten, die das Modell dann interpretiert und entsprechend handelt. Dies kann Folgendes zur Folge haben:

- Weitergabe privater oder eingeschränkter Daten

- Ausführen unbeabsichtigter Aktionen (z. B. Senden von E-Mails, Ändern von Datensätzen)

- Manipulation der Ausgabe, um Fehlinformationen zu verbreiten oder Folgemaßnahmen auszulösen

Diese Risiken eskalieren in Systemen, in denen mehrere Modelle Informationen untereinander austauschen. So könnte beispielsweise eine in ein Dokument eingebettete bösartige Eingabeaufforderung eine KI-Zusammenfassung beeinflussen, die dann fehlerhafte Erkenntnisse an nachgelagerte Systeme weitergibt.

Da KI zunehmend in Geschäftsabläufe integriert wird, zielen Angreifer zunehmend auf diese Modelle ab, um das Vertrauen zu gefährden, Daten zu extrahieren oder Entscheidungen von innen heraus zu manipulieren.

2. Was sind Deepfake- und Voice-Cloning-Angriffe?

Deepfake-Angriffe verwenden KI-generierte Audio- oder Videoaufnahmen, um sich in Echtzeit als Personen auszugeben. Gepaart mit Social-Engineering-Taktiken werden diese Tools für Betrug, Diebstahl von Zugangsdaten und unbefugten Systemzugriff eingesetzt.

Das Klonen von Stimmen ist besonders gefährlich geworden. Mit nur wenigen Sekunden aufgezeichneter Sprache können Bedrohungsakteure Audiodaten erzeugen, die den Tonfall, das Tempo und den Tonfall imitieren. Diese geklonten Stimmen werden dann verwendet, um:

- sich bei dringenden Anrufen als leitende Angestellte oder Manager auszugeben

- Mitarbeiter zu Überweisungen oder Passwortrücksetzungen verleiten

- Umgehung von Sprachauthentifizierungssystemen

Deepfakes gehen noch einen Schritt weiter, indem sie synthetische Videos erzeugen. Bedrohungsakteure können in einem Videoanruf einen CEO simulieren, der vertrauliche Daten anfordert, oder in aufgezeichneten Clips auftreten, in denen Richtlinienänderungen "angekündigt" werden, die Desinformationen verbreiten. Das Ponemon Institute berichtete über einen Vorfall, bei dem Angreifer KI-generierte Nachrichten verwendeten, die sich während der Anmeldefrist für Sozialleistungen in einem Unternehmen als Personalabteilung ausgaben, was zum Diebstahl von Anmeldedaten geführt hat.

Da KI-Tools immer leichter zugänglich sind, können selbst kleine Bedrohungsakteure täuschend echte Imitationen erstellen. Diese Angriffe umgehen herkömmliche Spam-Filter oder Endpunkt-Schutzmechanismen, indem sie Vertrauen ausnutzen.

3. Was sind Angriffe auf Klassifizierungsmodelle (Adversarial Machine Learning)?

Angriffe auf Klassifizierungsmodelle manipulieren die Eingaben oder das Verhalten eines KI-Systems, um falsche Entscheidungen zu erzwingen, ohne notwendigerweise Malware zu schreiben oder Code auszunutzen. Diese Taktiken fallen unter die umfassendere Kategorie des feindlichen maschinellen Lernens.

Es gibt zwei Hauptstrategien:

- Umgehungsangriffe: Der Angreifer bastelt eine Eingabe, die ein Klassifizierungssystem dazu verleitet, sie falsch zu identifizieren, z. B. Malware, die harmlose Dateien nachahmt, um Antivirenprogramme zu umgehen.

- Vergiftungsangriffe: Ein Modell wird mit absichtlich verzerrten Daten trainiert oder feinabgestimmt, wodurch seine Fähigkeit, Bedrohungen zu erkennen, verändert wird.

Überwachte Modelle sind oft "überangepasst": Sie lernen bestimmte Muster aus Trainingsdaten und verpassen Angriffe, die nur geringfügig abweichen. Angreifer nutzen dies aus, indem sie Tools wie WormGPT (ein Open-Source-LLM, das auf offensive Aufgaben abgestimmt ist) verwenden, um Nutzdaten zu erstellen, die knapp außerhalb der bekannten Erkennungsgrenzen liegen.

Dies ist die Machine-Learning-Version eines Zero-Day-Exploits.

AI-Hacking vs. traditionelles Hacking: Die wichtigsten Unterschiede

KI-Hacker nutzen KI, um KI-Cyberangriffe zu automatisieren, zu verbessern und zu skalieren. Im Gegensatz dazu erfordern herkömmliche Hackerangriffe oft manuelle Skripterstellung, umfassendes technisches Know-how und einen erheblichen Zeitaufwand. Der grundlegende Unterschied liegt in der Geschwindigkeit, der Skalierbarkeit und der Zugänglichkeit: Selbst unerfahrene Angreifer können jetzt mit ein paar Eingabeaufforderungen und einer Consumer-GPU anspruchsvolle KI-gestützte Cyberangriffe starten.

Aspekt | AI-Hacking | Traditionelles Hacking |

|---|---|---|

Geschwindigkeit | Fast sofort mit Automatisierung | Langsameres, manuelles Scripting |

Qualifikationsanforderungen | Eingabeaufforderungsbasiert; niedrige Einstiegshürde, erfordert aber Zugriff auf das Modell und Abstimmung | Hoch; erfordert umfassende technische Kenntnisse |

Skalierbarkeit | Hoch - unterstützt mehrstufige Angriffe auf viele Ziele | Begrenzt durch menschliche Zeit und Mühe |

Anpassungsfähigkeit | Dynamisch - Die KI passt Nutzlast und Ausweichmanöver in Echtzeit an | Statische oder halb-anpassbare Skripte |

Angriffsvektoren | LLMs, Deepfakes, Angriffe auf Klassifizierungsmodelle, autonome Agenten | Malware, Phishing, manuelle Aufklärung und Exploits |

Vorbehalte | Kann unvorhersehbar sein; ohne menschliche Aufsicht fehlen Absicht und Kontext | Mehr strategische Kontrolle, aber langsamer und manuell |

KI-Missbrauch und gegnerisches maschinelles Lernen

Nicht bei allen KI-Bedrohungen geht es um die Generierung von Malware - einige zielen auf die KI-Systeme selbst ab. Angreifende Taktiken des maschinellen Lernens wie Prompt Injection und Model Poisoning können Klassifizierer manipulieren, die Erkennung umgehen oder die Entscheidungsfindung beeinflussen. Da KI in Sicherheitsabläufen immer wichtiger wird, machen diese Angriffe deutlich, dass robuste Tests und menschliche Aufsicht dringend erforderlich sind.

Wie KI zur Entwicklung von Malware missbraucht werden kann: Eine OPSWAT

Was früher fortgeschrittene Kenntnisse erforderte, ist heute mit ein paar Klicks erledigt.

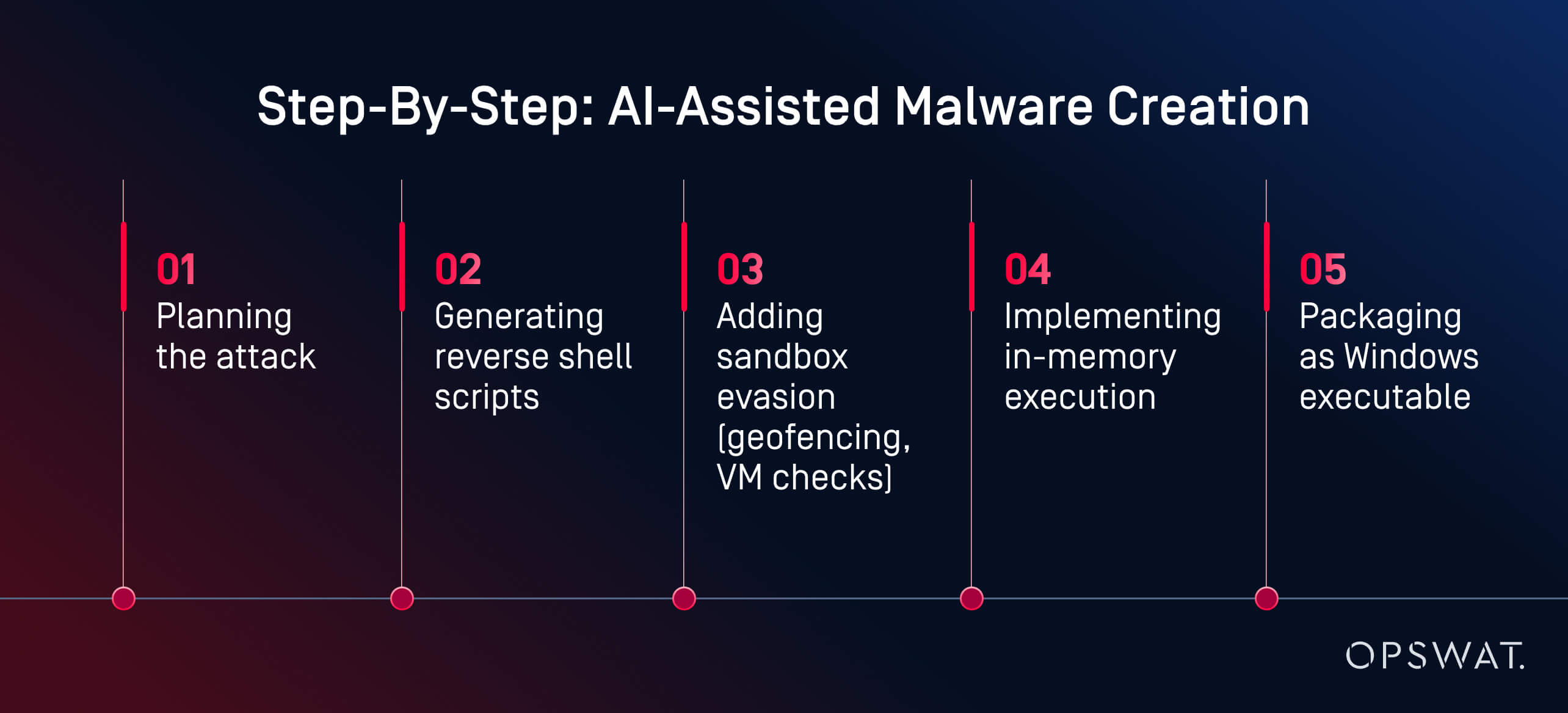

In einem Live-Experiment demonstrierte der OPSWAT Martin Kallas, wie KI-Tools verwendet werden können, um schnell, kostengünstig und ohne fortgeschrittene Kenntnisse ausweichende Malware zu erstellen. Mithilfe von HackerGPT erstellte Martin in weniger als zwei Stunden eine vollständige Malware-Kette. Das Modell leitete ihn durch jede Phase:

"Die KI hat mich durch jede Phase geführt: Planung, Verschleierung, Umgehung und Ausführung", erklärt Martin. Das Ergebnis war "... eine von der KI generierte Nutzlast, die sich der Erkennung durch 60 von 63 Antivirenprogrammen auf VirusTotal entzog." Auch Verhaltensanalysen und Sandboxing konnten den Virus nicht als bösartig einstufen.

Es handelte sich nicht um einen Nationalstaat. Es handelte sich nicht um einen Black Hat Hacker. Es handelte sich um einen motivierten Analysten, der öffentlich zugängliche Tools auf einer Consumer-GPU verwendete. Der Schlüssel zum Erfolg? Lokal gehostete, uneingeschränkte KI-Modelle. Mit über einer Million Open-Source-Modellen, die auf Plattformen wie Hugging Face zur Verfügung stehen, können Angreifer aus einer riesigen Bibliothek auswählen, sie für böswillige Zwecke feinabstimmen und ohne Aufsicht ausführen. Im Gegensatz zu Cloud-basierten Diensten können lokale LLMs so umprogrammiert werden, dass sie Sicherheitsvorkehrungen ignorieren und offensive Aufgaben ausführen.

"Das ist es, was ein motivierter Amateur bauen kann. Stellen Sie sich vor, was ein Nationalstaat tun könnte", warnte Martin. Sein Beispiel zeigt, wie der KI-Missbrauch Cyberkriminalität von einem qualifizierten Beruf in einen zugänglichen, KI-gestützten Arbeitsablauf verwandeln kann. Die Erstellung von Malware ist heute kein Engpass mehr. Die Erkennung muss sich schneller entwickeln als die Werkzeuge, die Angreifern heute zur Verfügung stehen.

Wie man sich gegen KI-gesteuerte Cyberangriffe verteidigt

Wir brauchen eine vielschichtige Verteidigung - nicht nur eine intelligentere Erkennung.

Die Verteidigung von Systemen gegen KI-gestützte Cyberangriffe erfordert eine mehrschichtige Strategie, die Automatisierung mit menschlichem Verständnis und Prävention mit Erkennung kombiniert. Führende KI-gestützte Cybersicherheitslösungen wie die fortschrittliche Plattform zur Bedrohungsabwehr von OPSWATintegrieren Prävention und Erkennung. Sehen Sie sich das Video an, um mehr zu erfahren.

AI-Sicherheitstests und Red Teaming

Viele Unternehmen setzen auf KI-gestütztes Red Teaming, um ihre Abwehrmaßnahmen gegen LLM-Missbrauch, Prompt Injection und die Umgehung von Klassifizierern zu testen. Diese Simulationen helfen dabei, Schwachstellen in KI-integrierten Systemen aufzudecken, bevor es Angreifer tun.

Red Teams verwenden gegnerische Eingabeaufforderungen, synthetisches Phishing und KI-generierte Nutzdaten, um zu bewerten, ob Systeme widerstandsfähig oder ausnutzbar sind. KI-Sicherheitstests umfassen auch:

- Fuzzing-Modelle für Prompt-Injection-Risiken

- Bewertung, wie LLMs mit manipulierten oder verketteten Eingaben umgehen

- Prüfung der Robustheit von Klassifikatoren gegenüber Ausweichverhalten

Sicherheitsverantwortliche beginnen auch damit, ihre eigenen LLMs auf prompte Lecks, Halluzinationen oder unbeabsichtigten Zugriff auf die interne Logik zu scannen, was ein entscheidender Schritt ist, da generative KI in Produkte und Arbeitsabläufe eingebettet wird.

Ein intelligenter Verteidigungsstapel: Der Ansatz der OPSWAT

Anstatt zu versuchen, KI mit KI in einer reaktiven Schleife zu bekämpfen, plädiert Martin Kallas für eine vielschichtige, proaktive Verteidigung. OPSWAT kombinieren Technologien, die den gesamten Lebenszyklus der Bedrohung abdecken:

- Metascan™ Multiscanning: Lässt Dateien durch mehrere Antiviren-Engines laufen, um Bedrohungen zu erkennen, die von Systemen mit nur einer Antiviren-Engine übersehen werden.

- MetaDefender Sandbox™: Analysiert das Dateiverhalten in isolierten Umgebungen und erkennt sogar KI-generierte Nutzdaten, die sich statischen Regeln entziehen

- Tiefes CDR™: Neutralisiert Bedrohungen, indem Dateien in sichere Versionen umgewandelt und eingebettete Exploits entfernt werden.

Dieser mehrschichtige Sicherheitsstack wurde entwickelt, um die unvorhersehbare Natur von KI-generierter Malware zu bekämpfen, einschließlich polymorpher Bedrohungen, speicherinterner Nutzlasten und Deepfake-Köder, die herkömmliche Tools umgehen. Da jede Schicht auf eine andere Stufe der Angriffskette abzielt, genügt eine einzige, um die Bedrohung zu erkennen oder zu neutralisieren und die gesamte Operation zu beenden, bevor sie Schaden anrichten kann.

Anwendungsfälle in der Industrie: Welche KI verwendet das FBI?

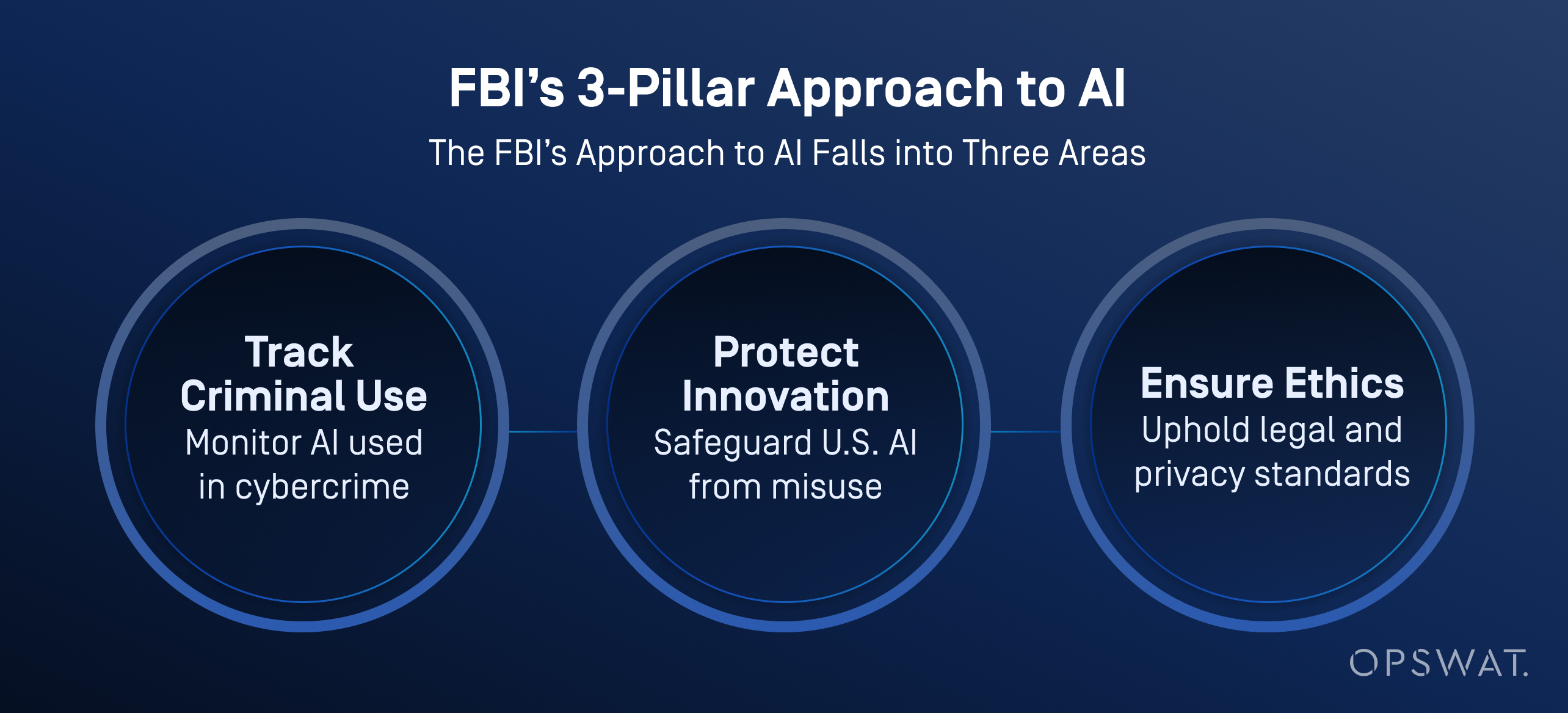

Das FBI und andere US-Behörden integrieren zunehmend künstliche Intelligenz in ihre Cyberverteidigungsmaßnahmen, nicht nur um Bedrohungen einzuteilen und zu priorisieren, sondern auch um die Datenanalyse, Videoanalyse und Spracherkennung zu verbessern.

Nach Angaben des FBI hilft die KI bei der Verarbeitung großer Datenmengen, um Ermittlungshinweise zu generieren, einschließlich Fahrzeugerkennung, Sprachidentifizierung und Umwandlung von Sprache in Text. Wichtig ist, dass das FBI eine strenge menschliche Aufsicht durchsetzt: Alle von der KI generierten Ergebnisse müssen von geschulten Ermittlern überprüft werden, bevor Maßnahmen ergriffen werden.

KI ist kein Ersatz für menschliche Entscheidungen. Das FBI betont, dass immer ein Mensch für die Ermittlungsergebnisse verantwortlich ist und dass KI in einer Weise eingesetzt werden muss, die die Privatsphäre, die bürgerlichen Freiheiten und die rechtlichen Standards respektiert.

Sind die Organisationen bereit?

Trotz der Zunahme von KI-gesteuerten Bedrohungen fühlen sich nur 37 % der Sicherheitsexperten darauf vorbereitet, einen KI-gesteuerten Cyberangriff abzuwehren, wie der State of AI Cybersecurity Report von Ponemon zeigt. Viele verlassen sich immer noch auf veraltete Cyber-Risikomanagementpläne und reaktive Erkennungsstrategien.

Der Weg nach vorn erfordert 4 wesentliche Schritte:

- Schnellere Einführung von KI-gestützten Verteidigungsinstrumenten

- Kontinuierliches Red Teaming und zeitnahe Risikoprüfung

- Aktive Nutzung von Multiscanning, CDR und Sandboxing

- Schulung von SOC-Analysten für die Arbeit mit automatisierten Untersuchungstools

Die KI hat die Regeln geändert. Es geht nicht darum, Menschen zu ersetzen, sondern ihnen die Werkzeuge an die Hand zu geben, um Angriffe abzuwehren, die jetzt selbständig denken. Erfahren Sie, wie unsere Plattform hilft, Dateien, Geräte und Datenströme in IT- und OT-Umgebungen zu sichern.

Häufig gestellte Fragen (FAQs)

Was ist AI-Hacking?

Unter KI-Hacking versteht man den Einsatz von Tools wie großen Sprachmodellen (LLM) zur Automatisierung oder Verbesserung von Cyberangriffen. Sie helfen Angreifern, Malware zu erstellen, Phishing-Kampagnen zu starten und Abwehrmaßnahmen schneller und einfacher als bisher zu umgehen.

Wie wird KI für Cyberkriminalität eingesetzt?

Kriminelle nutzen KI zur Generierung von Malware, zur Automatisierung von Phishing und zur Beschleunigung von Schwachstellen-Scans. Einige Tools, wie die in Dark-Web-Foren verkauften, können Angreifer sogar durch komplette Angriffsketten führen.

Was ist der Unterschied zwischen KI-Hacking und herkömmlichem Hacking?

Herkömmliches Hacken erfordert praktisches Programmieren, die Verwendung von Tools und technische Kenntnisse. KI-Hacking verringert diese Hürde mit Modellen, die Nutzdaten, Skripte und Phishing-Inhalte aus einfachen Aufforderungen generieren. Diese Techniken machen Angriffe schneller, skalierbarer und auch für Amateure zugänglich.

Wie kann KI zur Entwicklung von Malware missbraucht werden?

KI kann polymorphe Malware, Reverse Shells und Sandbox-evasive Payloads mit wenig Aufwand generieren. Wie in einer Live-Demo OPSWAT gezeigt wurde, hat ein nicht böswilliger Benutzer mithilfe von Open-Source-KI-Modellen, die auf einem Spiele-PC laufen, in weniger als zwei Stunden nahezu Zero-Day-Malware erstellt.

Kann KI Hacker ersetzen?

Noch nicht, aber sie kann viele technische Aufgaben übernehmen. Hacker wählen immer noch Ziele aus, während die KI Code schreibt, der Entdeckung entgeht und Angriffe anpasst. Die wahre Gefahr sind menschliche Angreifer, die durch die Geschwindigkeit der KI verstärkt werden.

Was ist ein KI-Hacker?

Ein KI-Hacker ist eine Person oder ein halbautonomes System, das KI nutzt, um Cyberangriffe zu starten, Malware zu automatisieren oder Phishing-Kampagnen in großem Maßstab durchzuführen.

Welche KI verwendet das FBI?

Das FBI nutzt KI für die Einstufung von Bedrohungen, forensische Analysen, die Erkennung von Anomalien und die Verarbeitung digitaler Beweise. Diese Tools helfen bei der Automatisierung von Ermittlungen und der Aufdeckung von Fällen mit hoher Priorität, während die Arbeitsbelastung der Analysten verringert wird.

Was ist ein Beispiel für einen KI-Angriff?

In einem realen Fall handelte es sich um KI-generierte Phishing-E-Mails während der Anmeldefrist für Sozialleistungen in einem Unternehmen. Die Angreifer gaben sich als Personalabteilung aus, um Anmeldedaten zu stehlen. In einem anderen Fall half KI bei der Automatisierung von Ransomware-Angriffen und zwang eine multinationale Marke, den Betrieb einzustellen.

Was sind KI-Cyberattacken?

KI-Cyberangriffe sind Bedrohungen, die mit Hilfe von künstlicher Intelligenz entwickelt oder ausgeführt werden. Beispiele hierfür sind KI-generiertes Phishing, Deepfake-Impersonationen, Prompt Injection und die Umgehung von Klassifizierern. Diese Angriffe umgehen häufig herkömmliche Verteidigungsmaßnahmen.

Wie nutzen Hacker und Betrüger KI, um Menschen ins Visier zu nehmen?

Hacker nutzen KI, um Phishing-E-Mails zu personalisieren, Stimmen für Telefonbetrügereien zu klonen und Deepfake-Videos zu erstellen, um Ziele zu täuschen. Diese Taktiken nutzen das Vertrauen der Menschen aus und machen selbst gut geschulte Nutzer anfällig für realistische, von KI erstellte Täuschungen.

Wie kann ich mich gegen KI-gestützte Angriffe schützen?

Verwenden Sie eine mehrschichtige Verteidigung: Multiscanning, Sandboxing, CDR und Red Teaming unter menschlicher Führung. KI-Angriffe sind schnell. Verteidiger brauchen Automatisierung, Kontext und Geschwindigkeit, um mithalten zu können.